Les développeurs doivent trouver une nouvelle forme de créativité

L'intégration de l'IA générative dans les processus de développement transforme radicalement l'expérience développeur, ainsi que les *soft* et *hard* skills attendues.

Quelles sont les perspectives de l'IA en 2024 ? Cet article décrypte les évolutions majeures qui influenceront les mois à venir, offrant un aperçu des tendances et des défis à venir.

Le Machine Learning entre dans une ère nouvelle en 2024. Comment industrialiser des applications LLM ? Pourquoi la miniaturisation des modèles va tout changer ? Quels impacts culturels et éthiques pour mon entreprise ? Quelles innovations et tendances de fond pour l'année à venir ? Autant de questions auxquelles nous allons répondre ici.

En 2024, les projets embarquants de l'IA générative vont connaître une accélération significative chez les entreprises les plus matures. Alors que certains seront encore au stade du prototype ou du PoC, les "tech companies" intègrent ces technologies directement dans leurs produits phares. Ainsi, Google Workspace ou la suite Microsoft Office, sont déjà augmentés par de l'IA générative, allant de simples suggestions de texte à la création d'assistants avancés et personnalisés. On va ainsi assister à une forte industrialisation des projets de Machine Learning dans le but d'améliorer la scalabilité et la fiabilité des modèles. De nombreux éditeurs vont inscrire durablement ces nouvelles fonctionnalités dans leurs roadmap produit pour proposer des outils toujours plus innovants à leurs utilisateurs.

Les approches basées sur le Retrieval Augmented Generation (RAG) ont notamment particulièrement le vent en poupe car elles permettent de créer des expériences plus fiables et plus personnalisées sans avoir à recourir au fine-tuning, qui est bien plus coûteux. Le succès de ces produits sera conditionné par leur adoption par des utilisateurs non-technophiles qui n'ont pas nécessairement eu l'occasion d'expérimenter et d'interagir avec des modèles via des interfaces de chat généralistes, comme ChatGPT, car il s'agit encore d'une large majorité de la population.

Cette démocratisation sera aussi portée par les outils et librairies open source qui permettent de faciliter la prise en main et le développement d'applications embarquant des LLM. Il s'agit d'un terrain extrêmement concurrentiel mais certains jeunes acteurs semblent déjà consolider leur positionnement comme LangChain, framework leader d'orchestration de LLM.

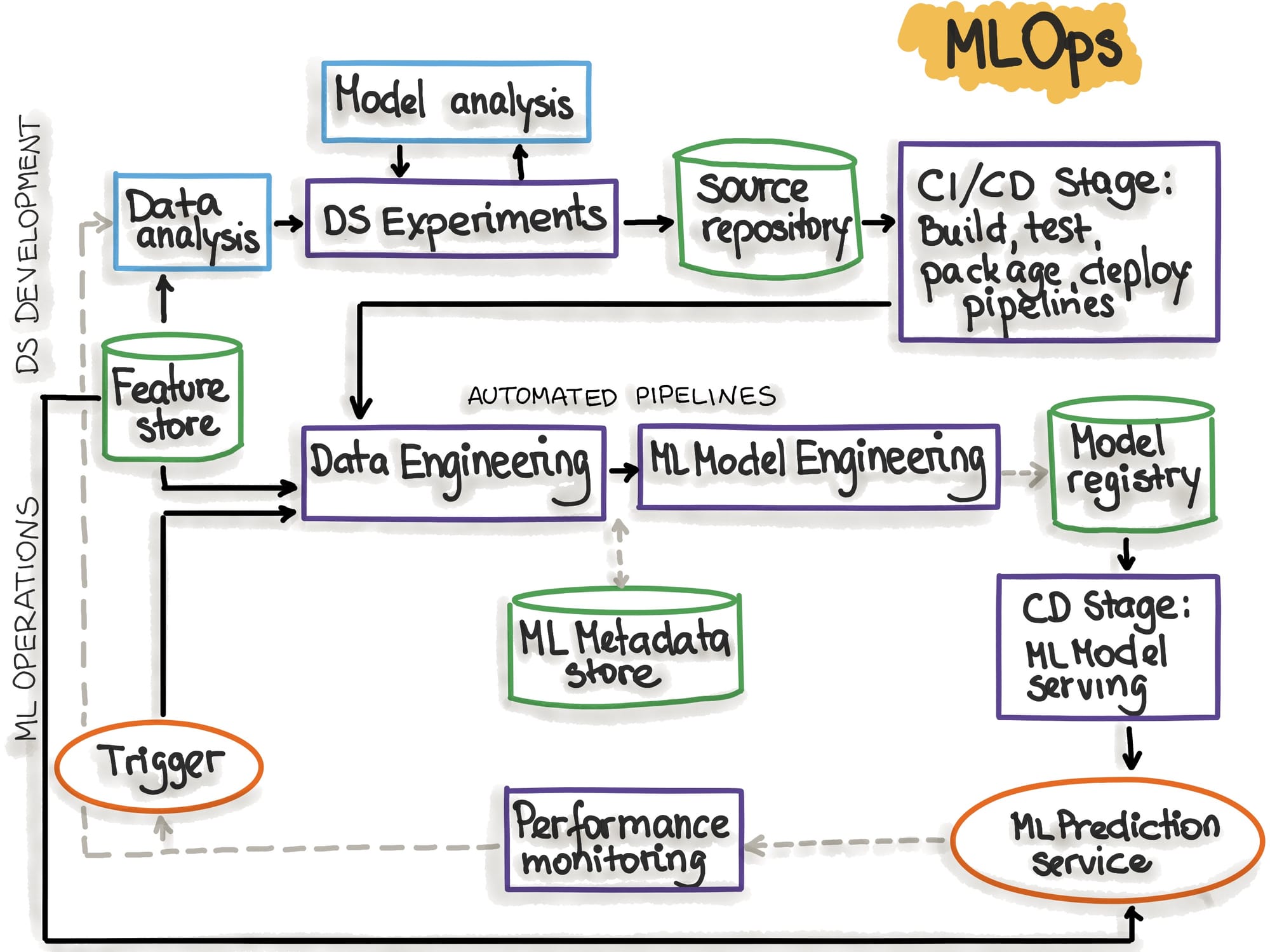

Les besoins en "monitoring" et les contraintes liées à l'utilisation des LLM en production stimuleront la demande de profils de Machine Learning Engineers, chargés de concevoir des chaînes MLOps (ou LLMOps) fiables. C'est pourquoi il est important d'expérimenter et d'effectuer une veille technologique afin de conserver une compréhension fine de l'écosystème qui s'est construit autour des IA génératives.

Des avancées notables ont été réalisées en 2023 grâce à des modèles de génération de texte tels que Llama 2, Starcoder, ou Mistral. Ces modèles ont ouvert de nouvelles perspectives en démontrant que la communauté open source, souvent dotée de ressources de calcul plus modestes (les "GPU-Poor"), pouvait créer des modèles plus compacts et plus efficaces que certains leaders.

Les modèles de taille réduite, nécessitant donc moins de puissance de calcul (tant pour l'entraînement que pour l'inférence), ouvrent de nouvelles opportunités notamment dans le domaine de la multimodalité (traitement du texte, des images, des sons, des vidéos, etc.) mais aussi du déploiement embarqué. Des entreprises, telles qu'Apple, orientent leur stratégie dans cette direction, en souhaitant rendre ces modèles disponibles directement sur leurs appareils.

Cette décentralisation de la recherche et de l'innovation facilite l'émergence de nouvelles idées et contribue à l'effervescence que l'on constate dans le domaine de l'IA générative. L'année à venir pourrait être celle où un modèle open source émergera pour rivaliser avec GPT-4, non seulement en termes de performances sur les benchmarks, mais surtout en matière d'expérience utilisateur.

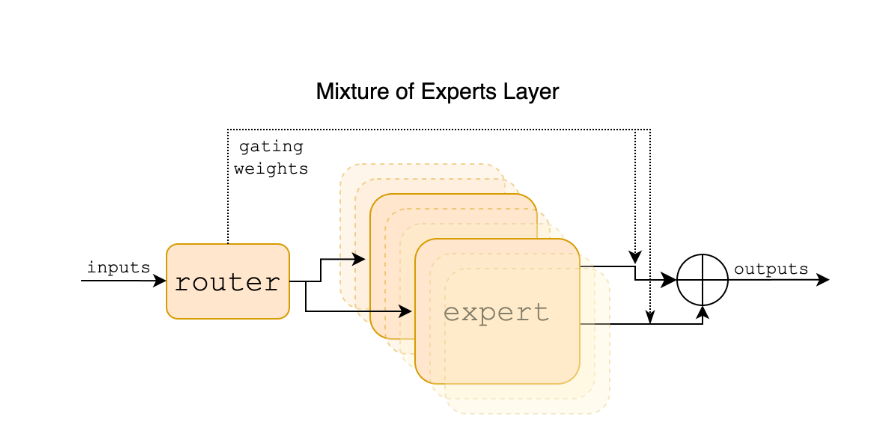

Le modèle "Mixtral" a connu un grand succès en fin d'année 2023, avec son architecture dite "MoE" (Mixture of Experts) qui a établi un nouveau standard pour un modèle de 56 milliards de paramètres (bien que cela puisse sembler beaucoup, le modèle GPT-3 en compte 125 milliards). Les modèles MoE peuvent être vus comme plusieurs "petits" LLM, chacun ayant acquis une spécialisation pour une tâche donnée. Cette approche permet généralement d'atteindre d'excellentes performances, car les questions ou prompts les plus complexes sont subdivisés en sous-problèmes plus simples (et parallélisables), avec des réponses provenant uniquement des modèles spécialisés sur le sujet ou la tâche en question.

L'influence de l'IA va au-delà des aspects techniques et imprègne désormais les conseils d'administration des entreprises. Souvent, ce sont les dirigeants qui impulsent l'intégration de la technologie dans la stratégie globale de l'entreprise. Cependant, en 2024, il est crucial de ne pas sous-estimer l'importance d'un accompagnement efficace lors de l'adoption de ces technologies, afin d'éviter un essoufflement de l'engouement initial. Les préoccupations liées à l'IA, qu'elle soit générative ou non, dépassent largement la simple question du remplacement des travailleurs par des robots (rassurez-vous, cela n'arrivera pas de sitôt). Des enjeux éthiques, juridiques et de qualité sont désormais au centre des préoccupations.

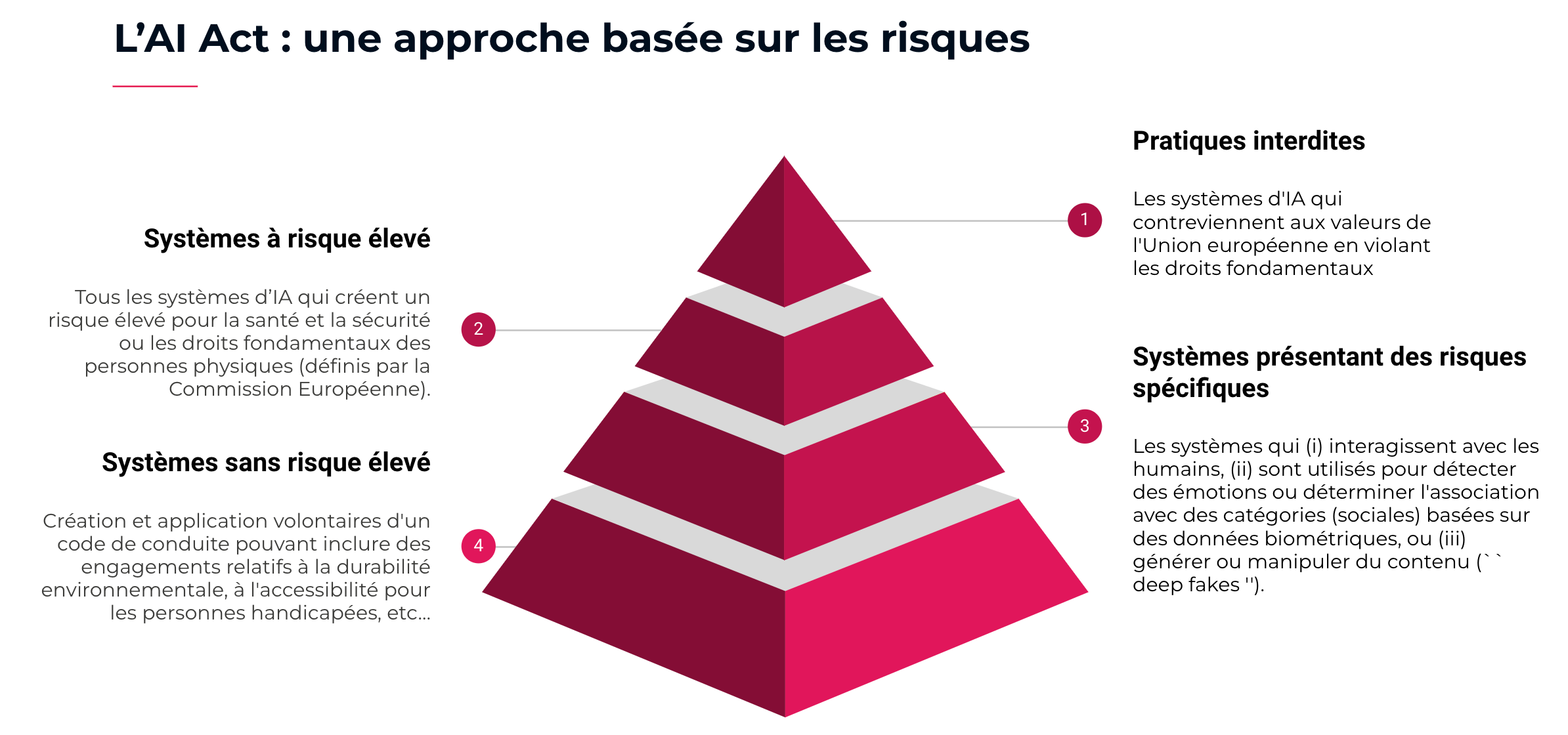

Par ailleurs, l'émergence de l'AI Act souligne la nécessité de se conformer à des réglementations de plus en plus strictes entourant l'utilisation de modèles de Machine Learning et de leurs applications. Accompagner les collaborateurs dans leurs premières expériences avec des outils génératifs est impératif pour répondre à leurs interrogations et les sensibiliser aux limites de cette technologie. En milieu professionnel, l'accent doit être mis sur la fiabilité, en s'orientant vers une IA explicative et digne de confiance.

Ainsi, les entreprises prospères seront celles qui auront compris qu'un simple outil, malgré ce qu'on peut entendre de certains vendeurs de rêve, ne suffit pas à augmenter la productivité globale des collaborateurs de 50%. Bien que la proposition d'outils de pointe constitue un atout différenciateur pour attirer et fidéliser les talents, il est essentiel de garantir que leur utilisation reste pertinente sans compromettre la créativité et l'ingéniosité individuelles. L'uniformisation résultant d'une utilisation systématique de générateurs de texte ou d'images doit être évitée. Bien que des outils comme la dernière version de Midjourney, avec ses performances photo-réalistes, soient des merveilles technologiques, il est essentiel de reconnaître leurs limites. Les phénomènes tels que les hallucinations, la contamination progressive des données ou les limitations imposées par les fournisseurs peuvent altérer la qualité des résultats. Récemment, on a d'ailleurs observé une tendance à la dégradation des performances des modèles d'Open AI.

En 2024, l'industrie va continuer à être confrontée à des pénuries de GPU, influencées également par la hausse des prix des crypto-monnaies. Cela représente une opportunité significative pour AMD, notamment pour s'imposer sur le marché des infrastructures d'entraînement de modèle de Deep Learning, actuellement dominé par Nvidia grâce à sa technologie CUDA et ses cartes graphiques spécialisées (citons notamment la A100 et ses 80Go de mémoire vive intégrée) . Il n'est pas exclu de voir émerger de nouveaux acteurs ; des rumeurs avaient d'ailleurs suggéré que le départ temporaire de Sam Altman (CEO d'Open AI) en novembre dernier était peut-être lié à son investissement massif dans une "venture" visant à devenir le prochain fournisseur de puissance de calcul pour les géants de l'IA.

Les premiers succès du Deep Learning, sur la classification d'image, ont eu lieu en 2011-12, suivi de l'arrivée des modèles Transformers en 2017 qui sont derrière les modèles d'IA génératives les plus performants. En extrapolant, il est donc probable que nous soyons dans une période propice à voir émerger pour une avancée majeure dans le domaine du Machine Learning (elle est peut être même déjà identifiée par les meilleurs experts). Ainsi, en 2024, il est judicieux de scruter les tendances qui vont dominer le paysage de la recherche fondamentale si, à la manière d'Open AI, on souhaite anticiper la prochaine vague d'innovations.

Personnellement, je place des espoirs dans les progrès de l'apprentissage par renforcement, qui joue déjà un rôle crucial dans l'entraînement des modèles de langage les plus performants grâce aux techniques telles que le RLHF (Reinforcement Learning with Human Feedback) ou le RLAIF (Reinforcement Learning with AI Feedback). Saluons à ce propos Thomas Simonini de Hugging Face, pour son cours approfondi sur le sujet. Il est probable que 2024 voie émerger les premiers robots équipés de modèles de langage qui les rendront capables d'interagir en langage naturel et d'exécuter précisément certaines tâches, par exemple, par commande vocale.

Tous ces challenge à venir sont particulièrement excitants et l'avenir s'annonce radieux pour les passionnés de l'IA, qu'ils soient chercheurs, ingénieurs, manager ou simplement utilisateurs.